Hoe een hele website downloaden voor offline gebruik

Na meer dan 11 jaar internet ervaring is er een ding niet veranderd; de vergankelijkheid. Wat vandaag nog beschikbaar was, kan morgen voorgoed verloren zijn. Daarom kan het soms wenselijk zijn om een hele website op uw lokale machine beschikbaar te stellen.

Mogen websites in hun geheel worden gedownload voor persoonlijk gebruik?

Tja, eigenlijk gebeurt dit de hele dag door. Wanneer u een pagina bekijkt, dan is er lokaal een kopie van de desbetreffende pagina op uw systeem aanwezig. Het verschil tussen dat u kijkt en u haalt de hele website binnen, is dat u de website niet alleen voor u zelf kunt gebruiken, maar op uw beurt weer kan op het internet kan publiceren. Wanneer u het laatste doet, dan bent uw wel in overtreding. Een ander punt is dat bandbreedte geld kost. Als u voor de grap telkens complete websites gaat downloaden, dan is de kans aanwezig dat webmasters daarvoor moeten gaan betalen. Dus haal alleen websites binnen die u echt wilt hebben en respecteer de moeite van de webmaster en haal hele grote bestanden niet automatisch op, plus beperk het aantal bestanden die u wilt hebben.

Hoe een website compleet downloaden?

Een spider is een programma waarmee u complete websites kunt downloaden. Wget is zo'n programma en is nog gratis ook. U kunt het hier downloaden. Hier kunt u een MS Windows versie downloaden Aangezien dit een commandline programma is, is het handig voor Windows gebruikers om ook Wgetgui te downloaden.

De te volgen stappen.

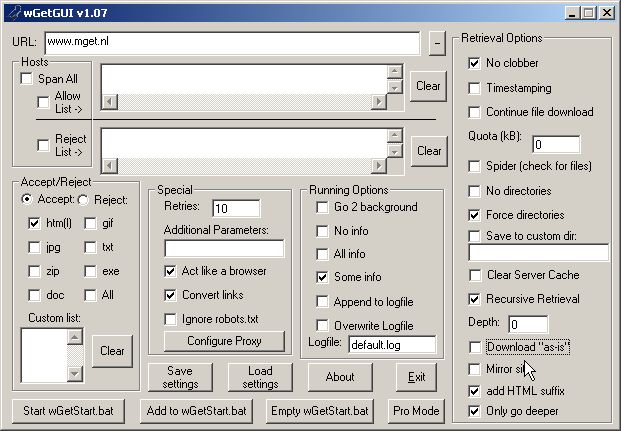

Start Wgetgui en het volgende scherm zult u zien.

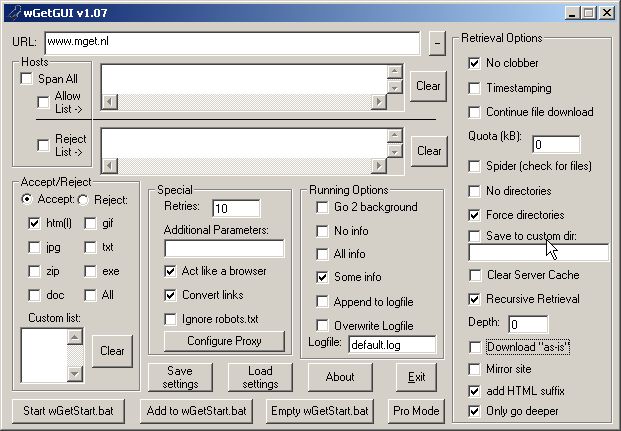

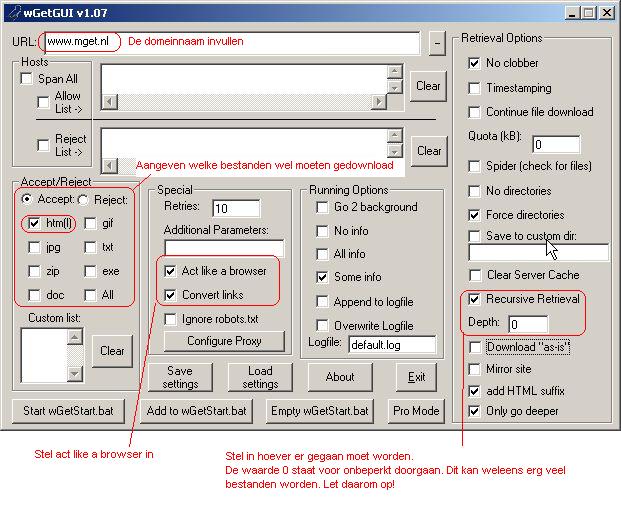

Configureer Wgetgui als volgt:

Let daarbij op de bestanden (hier alleen html bestanden), respecteer robots.txt en stel act like a browser functie in.

Wget kan nu gestart worden door op "Start Wgetstart.bat" knop te drukken.

Succes met leechen.